今、最も世の中的に注目を集めながら、最も“わかりにくい感”のある車の技術が「自動運転」かもしれない。なかでも、議論の的となっているのが「自動運転で事故が起きたら、その責任は人にあるのか、車にあるのか」という問題。そうしたなか、2018年に入ってウーバーの自動運転実験車が関わる死亡事故やオートパイロット作動中とみられるテスラ車が関わる事故なども発生。一般紙報道では「自動運転」や「半自動運転」という言葉が使われている(ここがまたややこしい)。しかし、この2つの事故は“似て非なるもの”なのだ。

文:西村直人/写真:shutterstock.com、編集部、TOYOTA

ウーバーの実験車と運転支援技術は「別物」

この件について、最初にはっきりと申し上げておきたいことが2つあります。ひとつ目は「半自動運転」という言葉は存在しないということです。

半自動運転を正確に定義するなら、それは走行領域を限定した「自動走行状態」となり、だからこそ一定の範囲(≑システムの許容範囲)を越える状況になった場合には、ドライバー(人)による運転操作が不可欠です。

ふたつ目は、現時点で発生している“実証実験車による事故”と、すでに普及が進んでいるACC(いわゆる先行車追従型のクルーズコントロール)をはじめとした、“運転支援技術の誤った使い方(≑設計思想にないNGとされる使い方)による事故”は、根っこからしてまったく別物だ、ということです。

よって、こうした一連の事故だけを捉えて「自動運転はダメだ」というレッテルを貼るのは早計です。以下、具体的に掘り下げます。

責任は「人か車」の片方だけにあるわけではない

まず“実証実験車による事故”。報道によると2018年3月、米アリゾナ州でウーバーが主体となって行っていた自動運転の実証実験で、テスト車両(ベースはボルボ XC90)が自動運転中、公道を斜め横断する自転車を押していた歩行者をはね死亡事故を起こしたとあります。

亡くなられた方にはお悔やみ申し上げるとともに、実証実験車における公道テスト走行は、残念ながら100%安全な運転環境を担保するものではない。つまり、自律自動運転システムをもたない一般の車両と同じように事故発生の可能性があることが明らかになりました。

また、このことはそうした事故発生の可能性を根絶するために、公道で実証実験を行うという大義を知らしめる結果にもつながっています。

事故原因は、米国の国家運輸安全委員会などが調査を行っています。一方で、事故発生時の車内動画が当時WEB上に公開されており、そこでは監視義務を負い、不測の事態には緊急停止ボタンを押すことができるスタッフが同乗していること、そして、そのスタッフの顔が下を向いた直後に事故が発生したようにも見受けられます。

この動画を見た方のなかには、「スタッフがよそ見をしていた」、「監視義務を怠った」から“人に責任がある”という意見のほか、「車載センサーが反応しなかった」から“車に責任がある”というコメントがあがっていますが、自律自動運転の実証実験車を開発された方々への取材や同乗試乗を行ってきた筆者は少し違った意見をもちました。

即ち、今回発生した実証実験車の事故を「人と車、どちらか一方だけの責任論」で幕引きすることや、開発が進む自律自動運転技術に対して「自動運転は危険」を論ずるには違和感があるからです。

“責任論”より事故原因の究明が先決

事故を起こした車両そのものを取材したわけではないので、これまでの経験則を前提とすれば、ウーバーの事故では確かにスタッフの顔が下を向いています。

しかし、その視線の先にセンサーの作動状況を示すモニターや周囲の道路環境を写し出しているPCモニターの類いがあったと考えれば、それは実証実験車を走行させるために必要なプロセスの一環だったのではないか……。

これは筆者の単なる憶測ではありません。

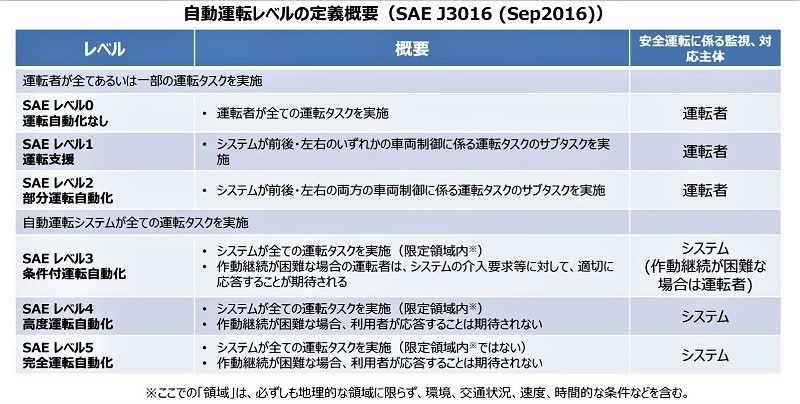

これまでSAEレベル1~5(図)の車両について開発者への取材や試乗を行ってきましたが、国内外の乗用車/大型トラックに実装された自律自動運転システムには、複数のモニターやデジタル計器類が不可欠。

同乗スタッフはそこからの情報をもとに自律自動運転システムが正しく機能しているか否かを判断しています。

そして、正しい運転操作が行われないと同乗スタッフが判断・予測した場合には、運転操作の権限を自律自動運転システムから同乗スタッフ(人)へと移譲(「オーバーライド」と言う)されることになっています。

でもそうなると、「ウーバーの実証実験車両はレベル4を担保するので、人の介入は想定していないのでは……」という疑問がわいてきます。

確かにSAEの定義では“限定領域内で人への移譲を求めず”、安全な運転環境の継続は“システム責任”とあります。

しかし、現段階は実証実験レベル。交通事故ゼロ、死傷事故ゼロを大きな目標のひとつとして掲げる自律自動運転の実現(実証実験ではなく市販化)に向け、世界中の自動車&部品メーカーや産官学連携の大規模プロジェクトがいくつも動いている最中なのです。

よって、こうした実証実験での事故を背景に、今もっとも望まれることは、

1.通常の交通事故発生時と同じプロセスで事故の発生原因を究明する

2.システムの異常(バグ)が原因かどうか究明する

3.より安全な実証実験の運用プロセスを確立する

この3点です。死亡事故となるとどうしても感情論が先に出てしまいますが、事故/死傷者ゼロという大きな目標の早期実現には何よりも建設的な議論が必要です。

コメント

コメントの使い方